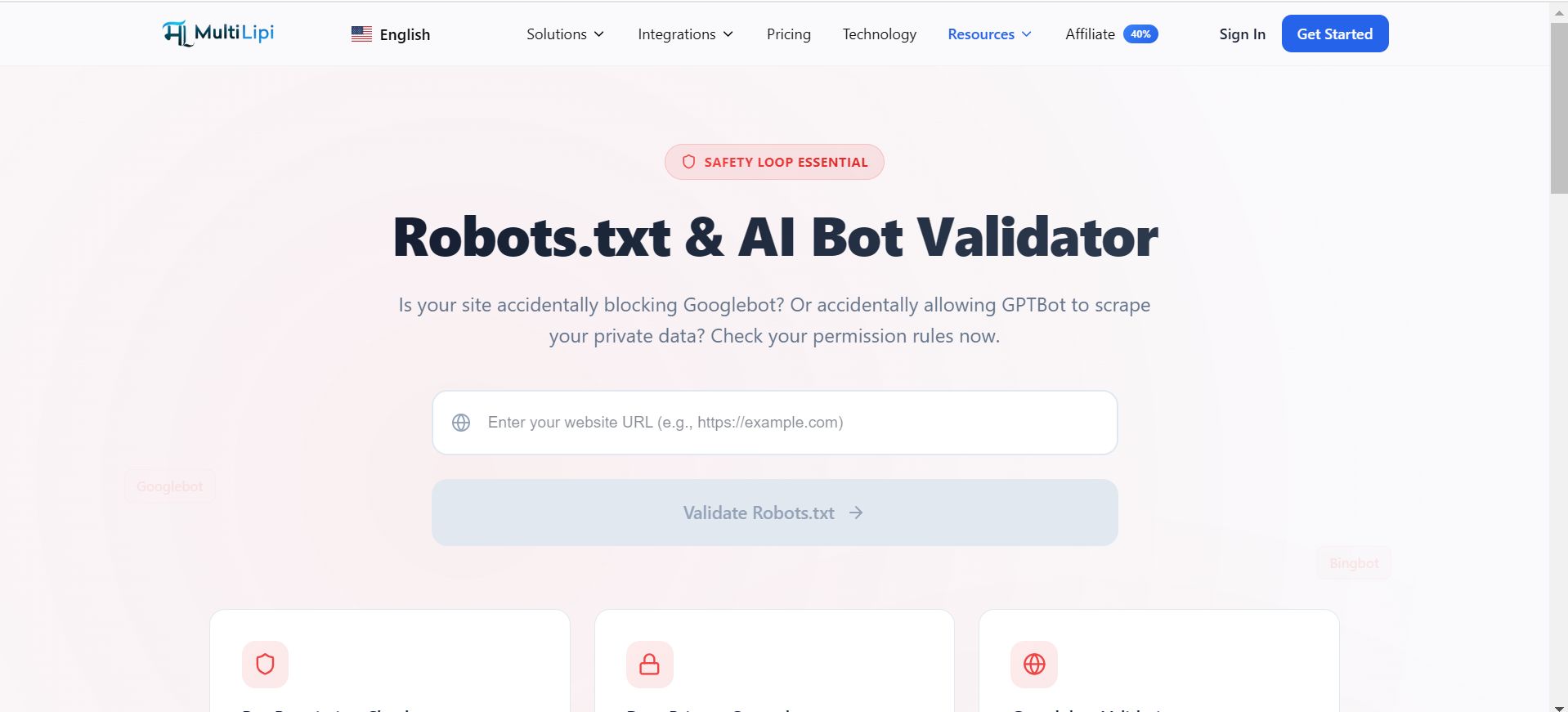

Audite as permissões do seu crawler e controle o scraping de dados por IA — sem custos.

Na era de IA generativa , o seu ficheiro robots.txt é o documento de segurança mais importante do seu servidor. É o guardião que diz ao Googlebot "Bem-vindo" e diz ao GPTBot (OpenAI) ou CCBot (Common Crawl) se lhes é permitido ingerir o seu conteúdo proprietário para treinar os seus modelos.

O MultiLipi Robots.txt Validator é uma ferramenta de engenharia gratuita concebida para auditar as suas regras de permissões. Garante que não está a bloquear acidentalmente o tráfego SEO enquanto verifica a sua posição sobre agentes de raspagem por IA.

O "Ciclo de Segurança" Essencial

Visibilidade SEO vs. Privacidade por IA.

Um único erro de sintaxe neste ficheiro pode desindexar todo o seu site do Google. Por outro lado, uma regra em falta pode permitir que empresas de IA extraiam todo o seu arquivo de blogs sem compensação.

O Risco SEO

Bloquear o Googlebot ou o Bingbot destrói o seu tráfego.

O Risco de IA

Permitir GPTBot ou ClaudeBot significa que o seu conteúdo se torna dados de treino.

O Equilíbrio

A nossa ferramenta valida que as suas diretivas "Permitir" e "Despermitir" são sintaticamente corretas e direcionam os agentes específicos que pretende gerir.

O Protocolo de Auditoria

Como validar o seu gatekeeper.

Não assumas que as tuas permissões estão corretas. Verifica-os com os padrões de crawlers ativos.

Aceda à Ferramenta Gratuita

Navegue até ao Robots.txt Validador.

Endpoint de entrada

Introduza o seu domínio raiz (por exemplo, https://example.com).

Varredura de Execução

Clique no botão Validar Robots.txt.

Lógica da Revisão

Examine a verificação de sintaxe, análise específica de bots e acessibilidade.

Lógica da Análise:

Verificação da Sintaxe: Sinalizações de curingas inválidas ou erros de caminho

Análise Específica de Bots: Verifica especificamente permissões para agentes principais como Googlebot, GPTBot, Bingbot e CCBot

Alcançabilidade: Confirma que o ficheiro está acessível e devolve um código de estado 200 OK

Controlo do Grafo de Conhecimento

Decide quem aprende contigo.

Se é uma editora premium ou plataforma SaaS, pode querer bloquear scrapers genéricos de IA enquanto mantém os motores de busca ativos.

Cenário

Quer aparecer nos resultados de pesquisa do Google, mas não quer que o ChatGPT recite gratuitamente os seus artigos com paywall.

Solução

Use o validador para garantir que o seu User-agent: GPTBot Proibido: / a regra está corretamente implementada e é distinta da tua User-agent: * regras.

Sitemaps multilíngues

Ligar a sua infraestrutura.

O teu robots.txt é também a sala de mapas para os teus crawlers. Deve estar explicitamente ligado ao seu Sitemap XML.

O Cheque

A nossa ferramenta verifica que um Sitemap: https://yoursite.com/sitemap.xml A diretiva existe.

O Impacto Global

Isto é fundamental para descobrir os seus subdiretórios localizados (por exemplo, /fr/ , /es/ ). Se o crawler não conseguir encontrar o sitemap via robots.txt, as suas páginas traduzidas em profundidade podem permanecer por descobrir.